场景感知中通过廉价的图像弥合估计LiDAR点运动的差距

从立体图像估计3D场景流的框架

从立体图像估计3D场景流的框架

2020-11-01 ~ 2022-07-01 本项目部分得到中央高校基本科研业务费专项资金2020ZDPY0303,部分得到上海市教委和上海市“曙光”项目的资助。教育发展基金19SG08,部分由深圳市科技计划项目JSGG20201103094400002资助,部分由上海市科委21511101900资助,部分由英伟达公司资助。3D场景流表征当前时间点如何在3D欧几里得空间中流向下一个时间点,具有自主推断场景中所有对象的非刚性运动的能力。目前最先进的3D动态场景感知都比较依赖类似于LiDAR等传感器。KITTI 数据集中使用的彩色相机成本不超过800美元link ,而Velodyne HDL-64E LiDAR传感器的成本约为75,000 美元link 。自动驾驶或机器人技术也因配备了LiDAR而导致成本增加。立体相机系统可以为基于 LiDAR 的场景流估计方案提供低成本的备份系统。具体负责内容如下:

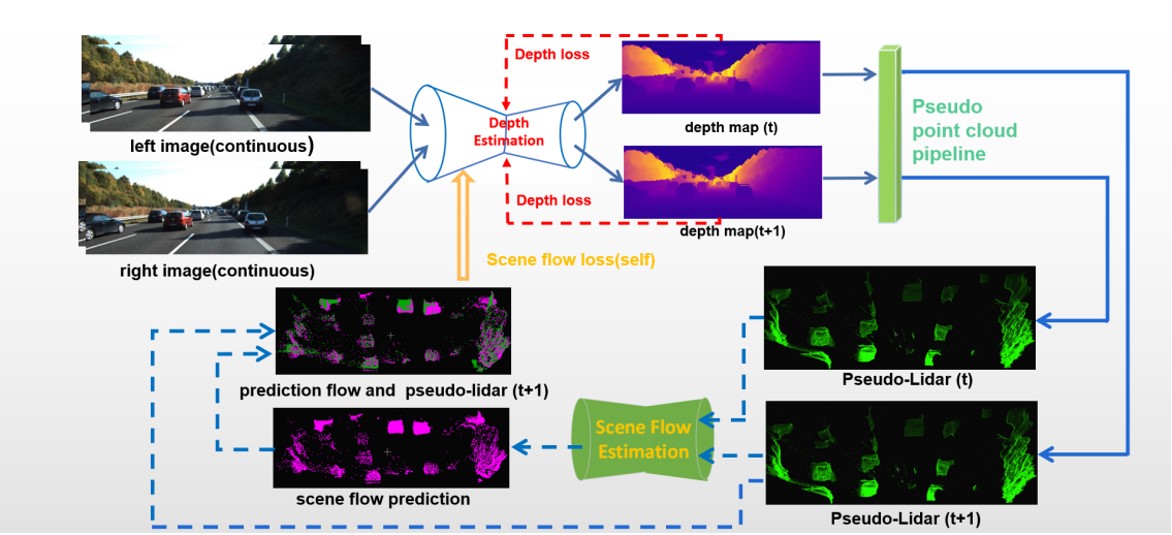

- 提出了一种从立体图像中学习 3D 场景流的新自监督方法。本项目是第一个将基于立体图像的伪激光雷达引入到 3D 场景流估计;

- 负责完成基于现有的深度估计算法生成伪LiDAR点云,并提出利用统计点云中每个点的邻居点去过滤伪LiDAR点云中大部分噪声点;

- 负责完成从生成的伪LiDAR点云中无监督学习3D场景流的全部代码写作;

- 负责完成论文的全部写作。

展示了本项目在3D场景感知中做出的探索,在公用的KITTI数据集上展示了提出的方法仅从双目图像中完成场景中3D点的运动矢量的估计。